下載app免費(fèi)領(lǐng)取會(huì)員

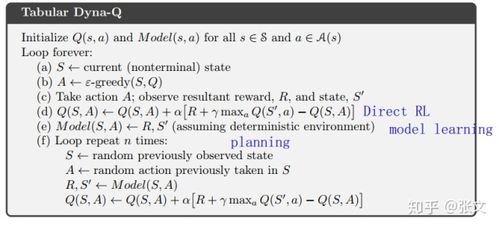

在機(jī)器學(xué)習(xí)領(lǐng)域,Dyna算法是一種強(qiáng)大的強(qiáng)化學(xué)習(xí)算法,它結(jié)合了模型學(xué)習(xí)和實(shí)際環(huán)境交互的優(yōu)點(diǎn)。在本文中,我們將介紹如何繼續(xù)進(jìn)行Dyna算法的計(jì)算。

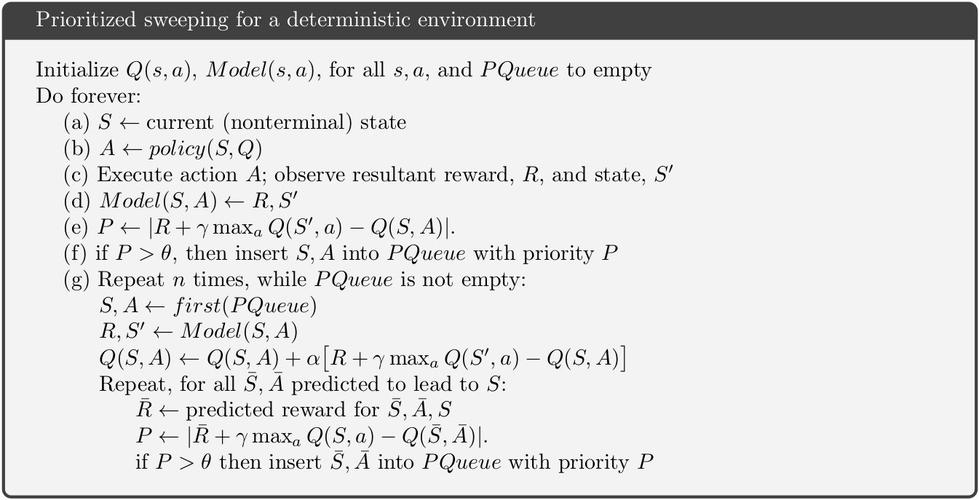

首先,讓我們回顧一下Dyna算法的基本原理。Dyna算法是基于Agent-Environment接口的模型學(xué)習(xí)算法,其中Agent代表學(xué)習(xí)算法本身,Environment代表外部世界。Dyna算法的目標(biāo)是通過模型學(xué)習(xí)來改進(jìn)Agent的策略,使其在與環(huán)境交互時(shí)能夠獲得更好的獎(jiǎng)勵(lì)。

為了繼續(xù)進(jìn)行Dyna算法的計(jì)算,我們需要以下幾個(gè)步驟:

1. 數(shù)據(jù)收集:首先,Agent需要與環(huán)境進(jìn)行交互,收集環(huán)境的狀態(tài)、行動(dòng)和獎(jiǎng)勵(lì)。這些數(shù)據(jù)將被用作訓(xùn)練模型的輸入。

2. 模型學(xué)習(xí):Agent使用收集到的數(shù)據(jù)訓(xùn)練模型,這可以是一個(gè)動(dòng)態(tài)模型或者一個(gè)價(jià)值函數(shù)模型。動(dòng)態(tài)模型用于預(yù)測環(huán)境的下一個(gè)狀態(tài),而價(jià)值函數(shù)模型用于評估不同狀態(tài)和行動(dòng)的價(jià)值。

3. 策略改進(jìn):Agent使用訓(xùn)練好的模型來改進(jìn)其策略。這可以通過使用貪心算法選擇具有最高價(jià)值的行動(dòng),或者使用探索算法來探索新的行動(dòng)。

4. 模型規(guī)劃:Agent使用訓(xùn)練好的模型進(jìn)行規(guī)劃。模型規(guī)劃是指Agent通過模型來模擬環(huán)境,并根據(jù)模擬結(jié)果來評估不同策略的效果。這樣可以避免在實(shí)際環(huán)境中嘗試每個(gè)策略,從而提高學(xué)習(xí)效率。

5. 迭代更新:Agent通過持續(xù)的數(shù)據(jù)收集、模型學(xué)習(xí)、策略改進(jìn)和模型規(guī)劃的迭代過程來不斷優(yōu)化其策略。這個(gè)過程可以根據(jù)具體問題的情況來調(diào)整,使Agent能夠更好地適應(yīng)環(huán)境。

通過以上步驟,Dyna算法可以不斷地學(xué)習(xí)和改進(jìn)Agent的策略,從而在與環(huán)境交互時(shí)獲得更好的獎(jiǎng)勵(lì)。然而,在實(shí)際應(yīng)用中,還有一些其他因素需要考慮:

1. 模型選擇:Agent在模型學(xué)習(xí)時(shí)需要選擇適合的模型。這可以是線性模型、非線性模型、深度神經(jīng)網(wǎng)絡(luò)等。模型的選擇將直接影響算法的性能和學(xué)習(xí)效果。

2. 探索與利用的平衡:在策略改進(jìn)過程中,Agent需要在探索未知行動(dòng)和利用已有知識(shí)之間進(jìn)行平衡。過于保守的策略可能會(huì)錯(cuò)過一些有利的行動(dòng),而過于冒險(xiǎn)的策略可能會(huì)導(dǎo)致學(xué)習(xí)的不穩(wěn)定。

3. 計(jì)算資源:Dyna算法在計(jì)算上可能非常昂貴,特別是在處理大規(guī)模數(shù)據(jù)和復(fù)雜模型時(shí)。因此,合理利用計(jì)算資源和采用高效的算法實(shí)現(xiàn)是非常重要的。

總結(jié)起來,繼續(xù)進(jìn)行Dyna算法的計(jì)算需要進(jìn)行數(shù)據(jù)收集、模型學(xué)習(xí)、策略改進(jìn)和模型規(guī)劃等步驟,并且需要考慮模型選擇、探索與利用的平衡以及計(jì)算資源的使用。通過不斷地迭代更新,Dyna算法可以不斷改進(jìn)Agent的策略,從而在與環(huán)境交互時(shí)獲得更好的獎(jiǎng)勵(lì)。

本文版權(quán)歸腿腿教學(xué)網(wǎng)及原創(chuàng)作者所有,未經(jīng)授權(quán),謝絕轉(zhuǎn)載。

下一篇:Dynamo教程 | 如何判斷dyna計(jì)算時(shí)間

推薦專題

- Dynamo教程 | 詳解dynamo網(wǎng)絡(luò)的節(jié)點(diǎn)

- Dynamo教程 | 如何在DM中實(shí)現(xiàn)旋轉(zhuǎn)

- Dynamo教程 | 如何利用Dynamo自動(dòng)生成結(jié)構(gòu)柱類型?Dynamo與“7”字形結(jié)構(gòu)柱

- Dynamo教程 | dynamo的墻體貼圖技巧

- Dynamo教程 | DJ技能訓(xùn)練課程

- Dynamo教程 | 篩選指定數(shù)據(jù)的list方法

- Dynamo教程 | 參數(shù)化 DDT

- Dynamo教程 | 在Revit中安裝Dynamo的步驟

- Dynamo教程 | 高空景觀師:創(chuàng)作摩天輪的設(shè)計(jì)師

- Dynamo教程 | 如何打開dyn